Les coûts de l'IA sont jusqu'à 15 fois plus chers pour les langues autres que l'anglais

Le langage que vous utilisez pour un grand modèle de langue (LLM) peut avoir un énorme impact sur son coût et créer une division de l'IA entre les anglophones et le reste du monde. Une étude récente montre que, en raison de la façon dont des services comme OpenAI mesurent et facturent les coûts de serveur, les entrées et les sorties en langue anglaise sont beaucoup moins chères que celles dans d'autres langues. Le chinois simplifié coûte environ deux fois plus cher, l'espagnol 1,5 fois le prix et la langue Shan coûte 15 fois plus cher.

Une tarification à l'avantage de l'anglais

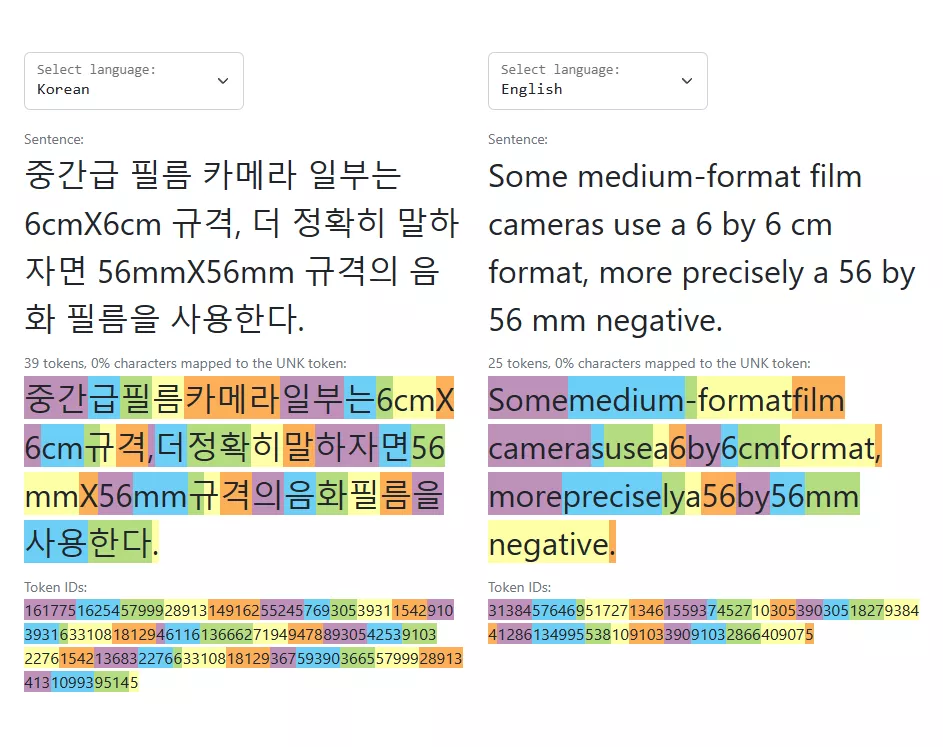

L'analyste Dylan Patel (@dylan522p) a partagé une photographie qui mène à une recherche menée par l'Université d'Oxford. Celle-ci a découvert qu'une phrase écrite en birman coûte 198 jetons à traiter par un LLM, alors que cette même phrase en anglais coûte seulement 17 jetons. Les jetons représentant le coût en puissance de calcul pour accéder à un LLM via une API (comme le ChatGPT d'OpenAI ou le Claude 2 d'Anthropic), cela signifie que la phrase en birman coûte 11 fois plus cher via le service que celle écrite en anglais.

The cost of LLM inference varies hugely based on the language for GPT-4 and most other common LLMs.

— Dylan Patel (@dylan522p) July 28, 2023

English is the cheapest.

Chinese is 2x English.

Languages like Shan + Burmese are 15x more expensive.

This is mostly because of how tokenizers work so need to output more tokens pic.twitter.com/Y7De09pb4w

Le modèle de tokenisation (qui voit les entreprises d'IA convertir l'entrée de l'utilisateur en coût de calcul) signifie que dans un monde moins qu'idéal, les modèles accessibles en dehors de la fenêtre de la langue anglaise sont beaucoup plus chers à accéder et à entraîner. C'est parce que des langues comme le chinois ont une structure différente, plus complexe (soit grammaticalement soit par le nombre de caractères) que l'anglais, ce qui résulte en leur taux de tokenisation plus élevé.

La "tokenisation" injuste entre les langues

Par exemple, selon le tokenizer de GPT3 d'OpenAI, donner à quelqu'un un token de "your affection" serait seulement deux tokens en anglais, mais huit tokens en chinois simplifié. C'est vrai même si le texte en chinois simplifié compte seulement 4 caractères (你的爱意) et celui en anglais en compte 14. La page de la justice de tokenisation d'Aleksandar Petrov et al a un certain nombre de graphiques et d'outils que vous pouvez utiliser pour voir la disparité entre les langues.

OpenAI lui-même a une page assez utile qui explique comment il monétise l'accès à l'API et l'utilisation de son modèle ChatGPT, qui comprend même l'accès à un outil de tokenisation que vous pouvez utiliser pour tester le coût en token par incitation. Là, nous voyons qu'un token est d'environ 4 caractères en anglais, et que 100 tokens seraient environ 75 mots anglais. Mais cette mathématique ne peut tout simplement pas être appliquée à une autre langue, comme le dit clairement OpenAI.

La façon dont les mots sont divisés en tokens est également dépendante de la langue. Par exemple, "Cómo estás" ("Comment vas-tu" en espagnol) contient 5 tokens (pour 10 caractères). Le ratio token-caractère plus élevé peut rendre l'implémentation de l'API plus coûteuse pour les langues autres que l'anglais.

La domination coûteuse de l'anglais dans l'IA

Il n'y a vraiment aucune compétition contre le rapport coût-efficacité de l'anglais dans les coûts liés à l'IA ; le chinois, par exemple, coûte deux fois plus cher que l'anglais en termes de tokens requis par sortie. Mais c'est simplement le reflet des données d'entraînement disponibles que les entreprises d'IA ont (jusqu'à présent) utilisées pour entraîner leurs modèles. Si l'explosion de l'IA a fait une chose pour le monde, c'est de montrer à quel point les données émergentes de haute qualité (celles qui sont créées comme un enregistrement de la vie) sont vraiment précieuses.

La différence de coût a déjà conduit un certain nombre de pays à lancer leurs propres initiatives pour entraîner et déployer un LLM en langue maternelle. La Chine et l'Inde l'ont fait, et toutes deux ont affirmé la même chose : que leurs plans étaient nécessaires pour accompagner le rythme de l'innovation permis par les réseaux d'IA basés sur l'anglais. Et ce rythme est surtout limité par les coûts d'accès et d'entraînement.

Il est tout à fait naturel que tout le monde cherche à payer le moins possible pour autant que possible ; et ces dynamiques affectent directement le coût de l'entraînement et du déploiement des LLM en fonction de la langue de base. Il semble presque que cette affaire d'IA soit si complexe, et ses conséquences si vastes, que nous devons être très prudents à chaque petit pas que nous faisons.