Les GPU NVIDIA H100 établissent la norme pour l'IA générative dans le benchmark MLPerf

Les GPU NVIDIA H100 Tensor Core offrent les meilleures performances en IA, en particulier sur les grands modèles de langage (LLM) qui alimentent l'IA générative. Les GPU H100 ont établi de nouveaux records sur les huit tests du dernier benchmark MLPerf publié aujourd'hui, excellant sur un nouveau test MLPerf pour l'IA générative.

Les performances des GPU H100

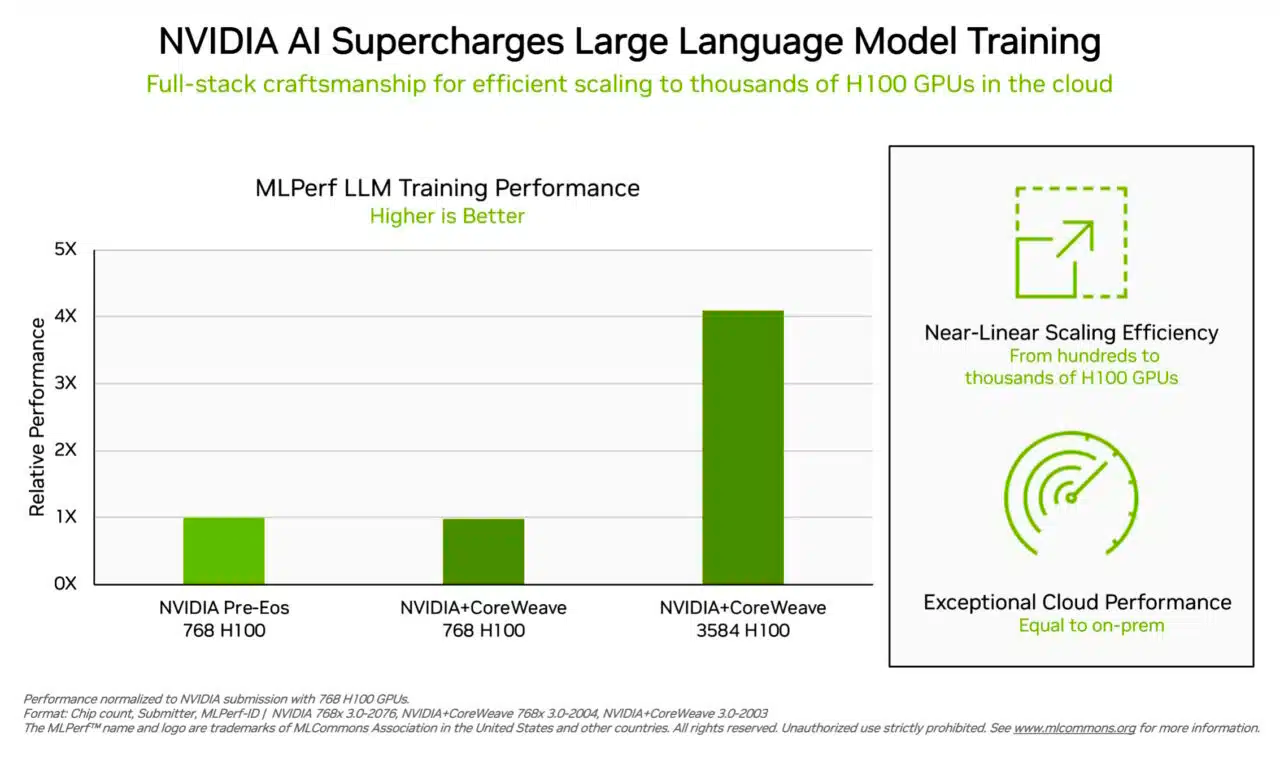

Par exemple, sur un cluster de 3 584 GPU H100 disponible commercialement, co-développé par la startup Inflection AI et exploité par CoreWeave, un fournisseur de services cloud spécialisé dans les charges de travail accélérées par GPU, le système a terminé le benchmark d'entraînement basé sur GPT-3 en moins de onze minutes.

Brian Venturo, co-fondateur et CTO de CoreWeave, a déclaré : "Nos clients construisent aujourd'hui des IA génératives et des LLM de pointe à grande échelle, grâce à nos milliers de GPU H100 sur des réseaux InfiniBand rapides et à faible latence. Notre soumission conjointe à MLPerf avec NVIDIA démontre clairement les grandes performances dont bénéficient nos clients."

Inflection AI et son IA personnelle

Inflection AI a exploité ces performances pour construire le LLM avancé derrière sa première IA personnelle, Pi, qui signifie intelligence personnelle. La société agira comme un studio d'IA, créant des IA personnelles avec lesquelles les utilisateurs peuvent interagir de manière simple et naturelle.

Mustafa Suleyman, PDG d'Inflection AI, a déclaré : "N'importe qui peut expérimenter la puissance d'une IA personnelle aujourd'hui basée sur notre modèle de langage à grande échelle de pointe qui a été formé sur le puissant réseau de GPU H100 de CoreWeave."

Les performances démontrées dans les benchmarks MLPerf

Les expériences utilisateur reflètent les performances démontrées dans les benchmarks MLPerf annoncés aujourd'hui. Les GPU H100 ont offert les meilleures performances sur chaque benchmark, y compris les grands modèles de langage, les systèmes de recommandation, la vision par ordinateur, l'imagerie médicale et la reconnaissance vocale. Ils étaient les seuls puces à exécuter tous les huit tests, démontrant la polyvalence de la plateforme d'IA NVIDIA.

L'efficacité à grande échelle

L'entraînement est généralement une tâche exécutée à grande échelle par de nombreux GPU travaillant en tandem. Sur chaque test MLPerf, les GPU H100 ont établi de nouveaux records de performance à grande échelle pour l'entraînement en IA.

Des optimisations à travers toute la pile technologique ont permis une mise à l'échelle des performances presque linéaire sur le test LLM exigeant à mesure que les soumissions passaient de centaines à des milliers de GPU H100.

Source : Nvidia