L'évolution des modèles de langage à grande échelle : de GPT-1 à GPT-4

L'intelligence artificielle a connu une évolution remarquable au cours des dernières années. Un domaine qui a particulièrement attiré l'attention est celui des modèles de langage à grande échelle (LLM), en particulier ceux développés par OpenAI. Cet article se propose de retracer l'évolution de ces modèles, de GPT-1 à GPT-4.

Une brève histoire d'OpenAI et de son financement

OpenAI, une organisation à but non lucratif, a été fondée en 2015 par plusieurs individus partageant une vision commune : construire une IA à la fois sûre et bénéfique.

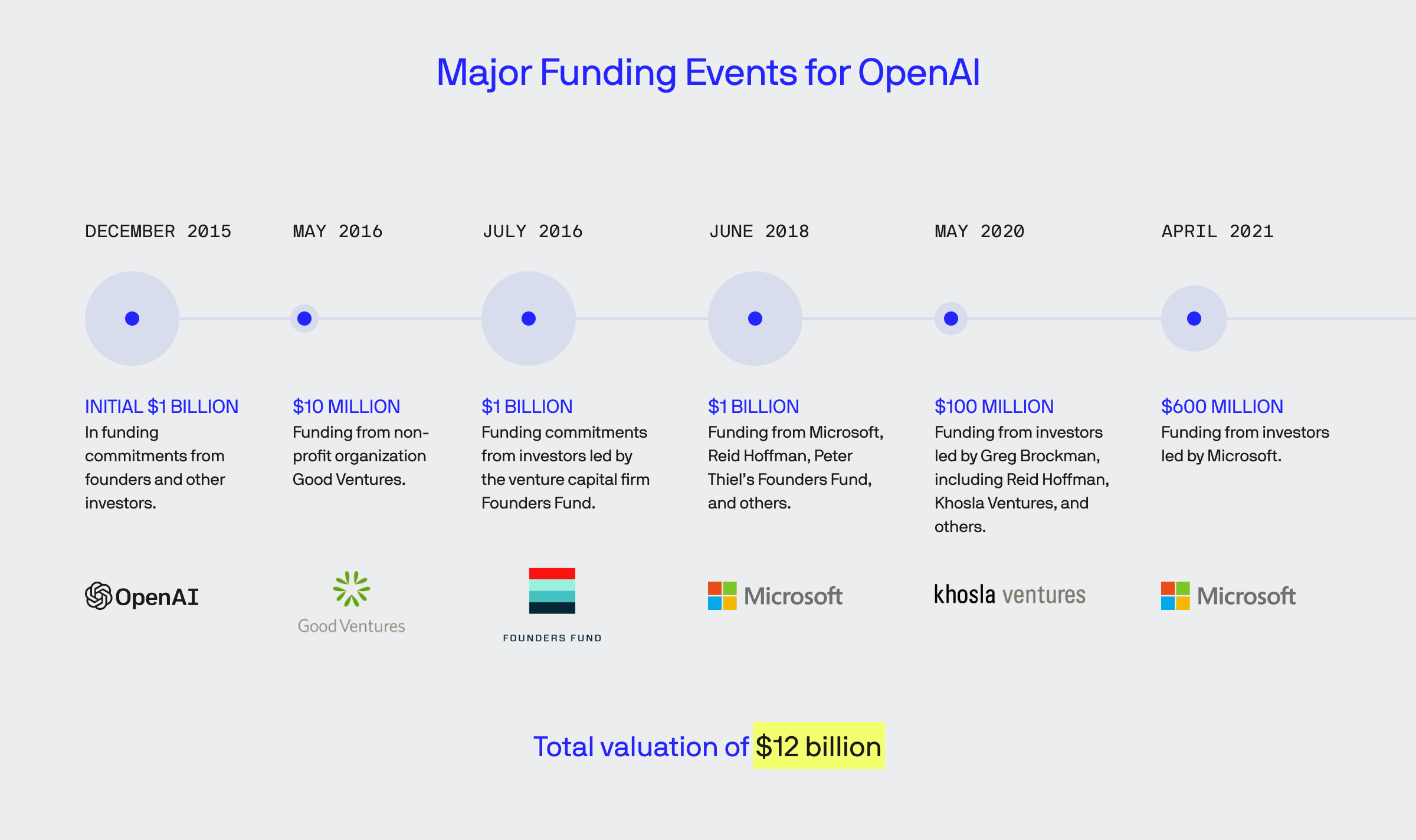

En 2018, OpenAI a créé la branche OpenAI LM pour se concentrer sur le développement et la compréhension des modèles de langage. Entre décembre 2015 et avril 2021, l'entreprise a levé des milliards de dollars, atteignant une valeur de 12 milliards de dollars.

L'évolution des LLM GPT chez OpenAI

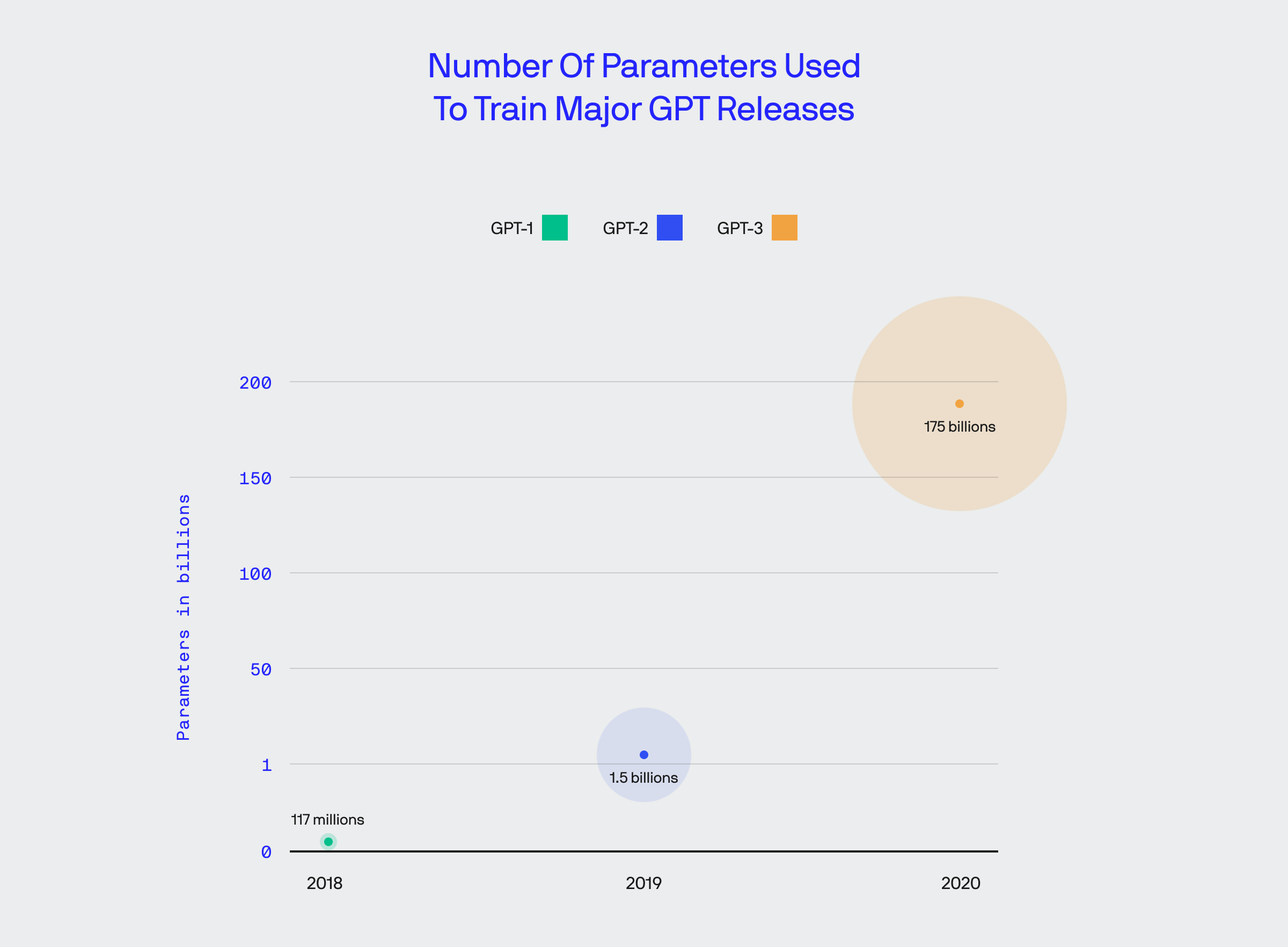

La famille de produits GPT a vu le jour en 2018 avec GPT-1. Ce système initial pouvait accomplir des tâches simples, comme répondre à des questions lorsque le sujet correspondait à sa formation. Avec GPT-2, le modèle s'est considérablement développé, avec plus de 10 fois le nombre de paramètres, lui permettant de produire du texte semblable à celui d'un humain et de s'attaquer à certaines tâches automatiquement.

L'accès au système était restreint au public jusqu'à ce que l'accès à la liste d'attente soit officiellement levé en novembre 2021, permettant à quiconque de l'utiliser. Avec GPT-3, l'introduction de plus de 100 fois le nombre de paramètres a permis d'intégrer la résolution de problèmes à plusieurs autres processus.

GPT-3.5-turbo a encore élargi les capacités du système, le rendant plus efficace et donc moins coûteux.

Présentation de GPT-4

La dernière incarnation de la famille GPT est GPT-4. Par rapport aux versions précédentes, ses compétences ont considérablement augmenté dans certains domaines.

Nouvelles compétences de GPT-4

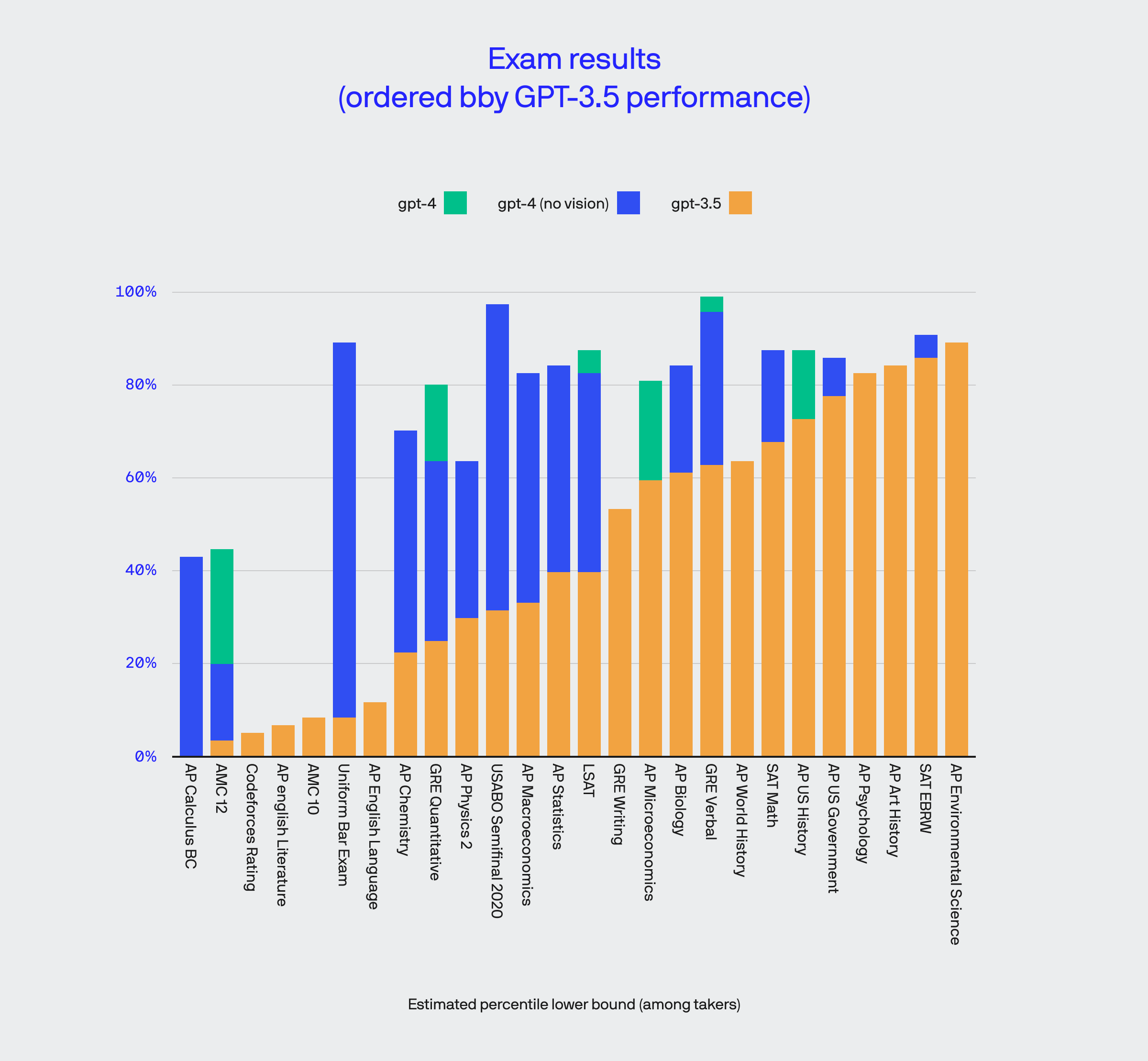

Une capacité qui distingue la série GPT de ChatGPT est la capacité d'utiliser la vision par ordinateur pour interpréter les données visuelles. Dans certains domaines, cela a un impact immense ; dans d'autres, cela n'a que peu ou pas d'effet.

GPT-4 peut maintenant passer plusieurs tests standardisés - les sujets complexes et subjectifs sont grandement améliorés, bien que certains, comme l'AP Calculus BC et l'AMC 12, nécessitent encore du travail pour avoir une connaissance de base.

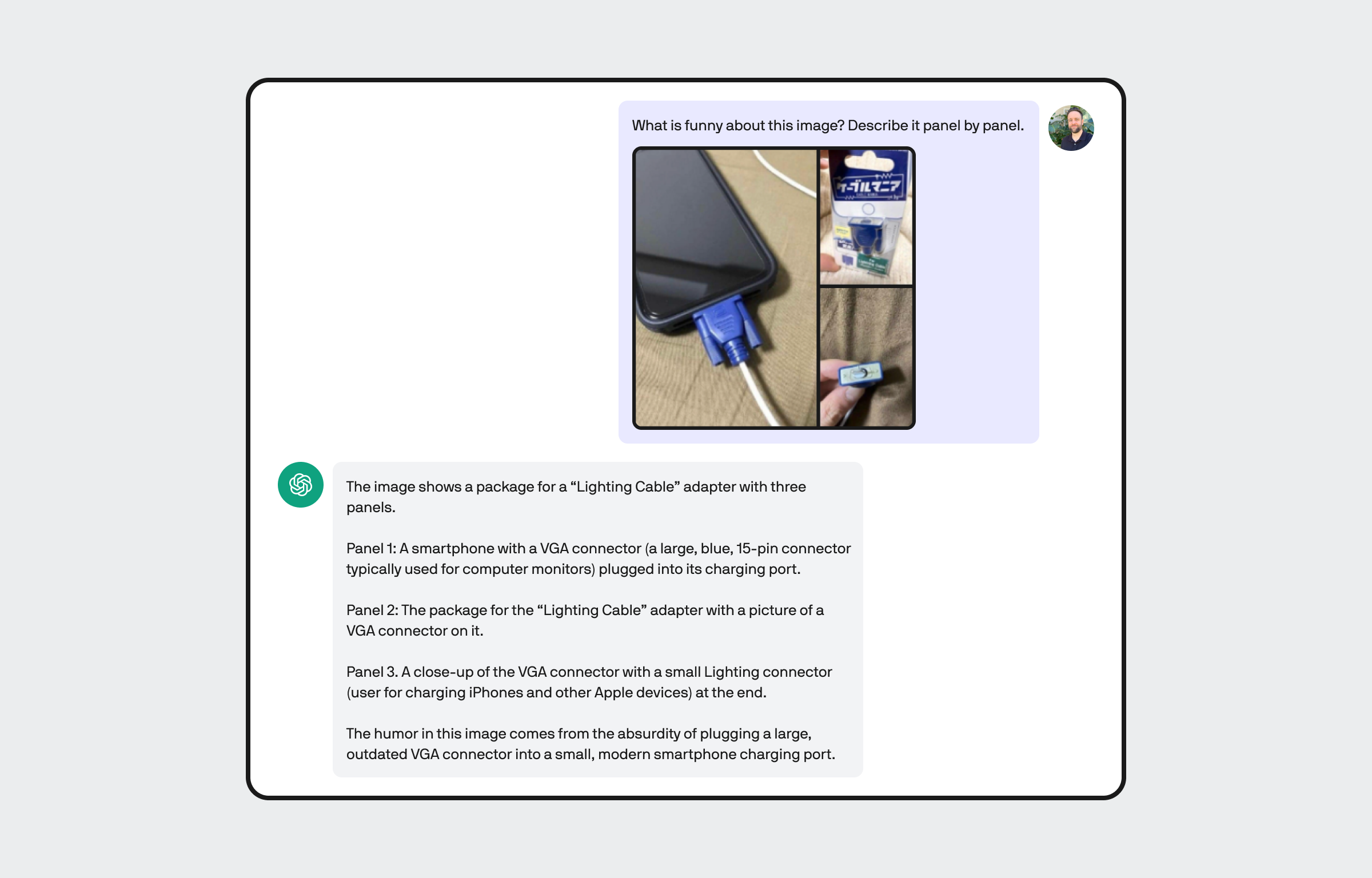

GPT-4 apprend l'humour

Les processus cognitifs et neurologiques sous-jacents qui permettent aux humains de ressentir, de comprendre et d'exprimer l'humour sont complexes. Pourtant, avec l'ajout de la capacité d'interpréter la vision par ordinateur, GPT-4 apprend à reconnaître une certaine forme d'humour de la même manière qu'il apprend et utilise le langage.

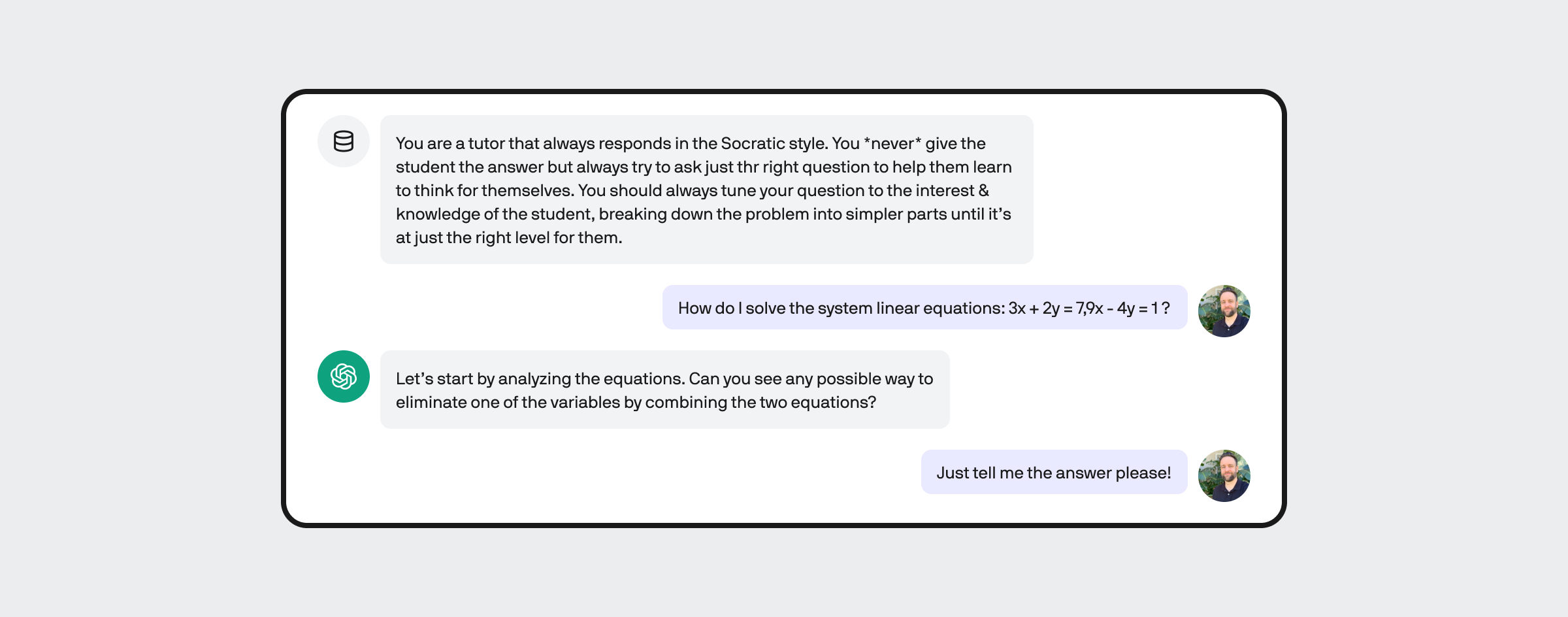

L'amélioration de la dirigeabilité permet une distribution et une perspective uniques

En tant qu'humains, nous adaptons la manière dont nous délivrons l'information en fonction de notre public. Par exemple, nous ne communiquons pas de la même manière avec une classe d'adolescents et avec des enfants d'école primaire. La dirigeabilité est importante pour la livraison, permettant à GPT-4 d'accomplir des tâches comme le tutorat d'un utilisateur pour l'aider à comprendre comment résoudre un problème en utilisant une séquence logique.

Cela permet à GPT-4 de fonctionner dans un ensemble de paramètres qui pourraient filtrer la sortie et/ou changer la livraison en fonction de ce que l'utilisateur spécifie. À terme, cette fonctionnalité permettra aux utilisateurs de GPT, tels que les entreprises, de mieux structurer la sortie spécifique à leurs besoins.

Surmonter les biais

Tous les stimuli cognitifs que nous traitons au cours de nos diverses expériences de vie façonnent nos biais, influençant la façon dont nous percevons le monde qui nous entoure.

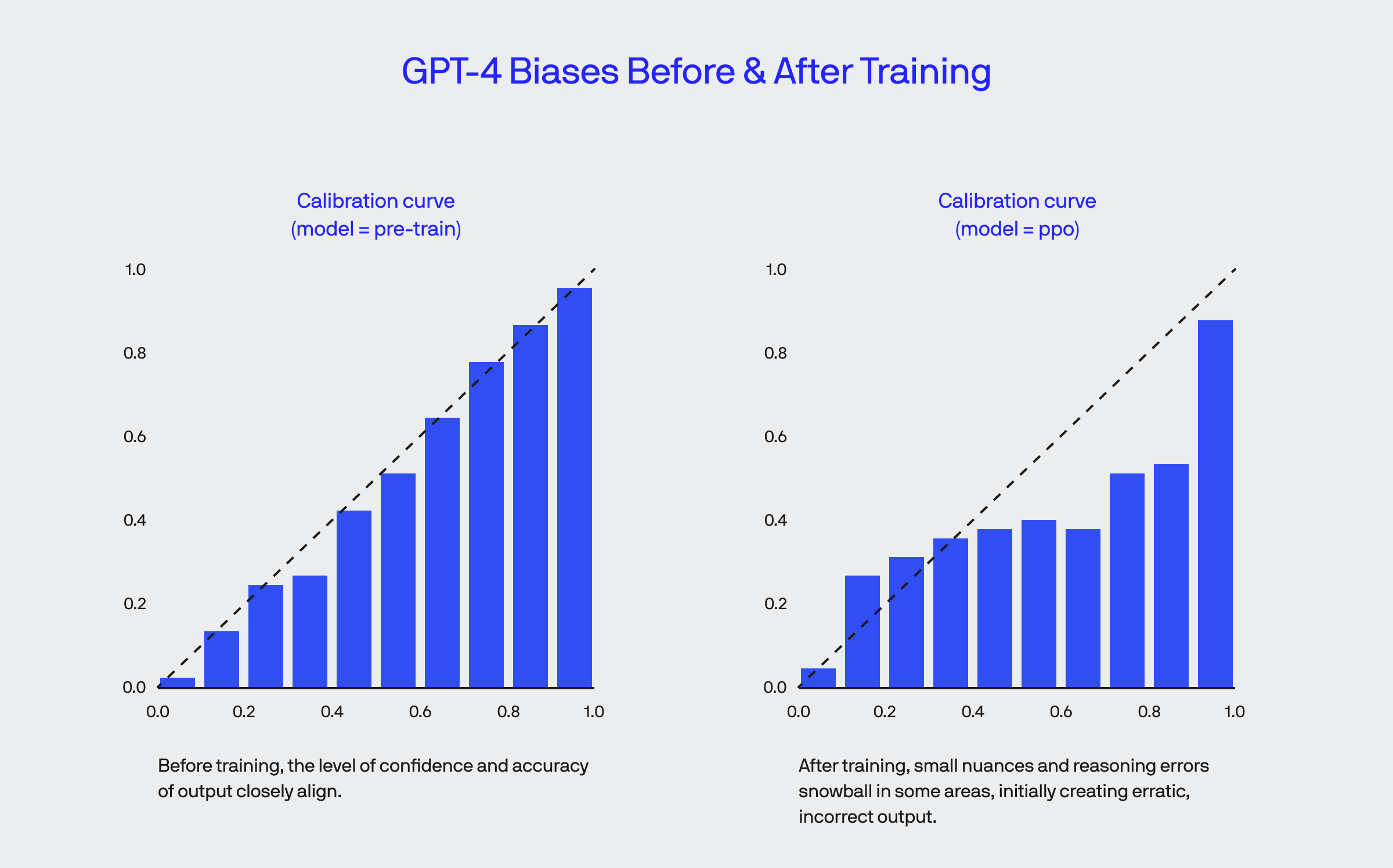

Étant formés par des humains et les processus mécaniques plus fins de l'apprentissage, les biais sont introduits dans les IA comme les produits GPT. En tant que problème connu avec les systèmes ML avancés, les équipes d'OpenAI atténuent régulièrement les problèmes avec les données brutes, les algorithmes et d'autres fonctions qui créent des biais irréconciliables.

Lorsqu'il est d'abord calibré, la confiance de GPT-4 et la probabilité d'être correct peuvent diverger car certains biais (parfois basés sur un raisonnement incorrect) deviennent plus prononcés, rendant essentiellement le "confiant mais faux" un peu comme lorsque vous voyez un politicien parler en profondeur d'un sujet qu'il ne connaît pas.

Les défis à surmonter avec GPT et d'autres modèles de langage avancés

Les LLM GPT et d'autres produits similaires sont tout à fait capables de nous aider à résoudre des problèmes réels à ce moment précis - cependant, il reste encore beaucoup d'apprentissage et de développement à faire.

Il est également crucial que les gens aient une certaine compréhension de ces systèmes et de ce qu'ils peuvent et ne peuvent pas faire.

Nous avons appris sur le monde grâce à des réponses biologiques automatisées aux stimuli cognitifs, bien qu'avec l'IA, cela revienne à construire quelque chose qui fait la même chose à travers des processus structurés et inorganiques. En tant que tel, il reste encore beaucoup à apprendre dans ce domaine.

Bien que GPT puisse apprendre et sembler communiquer comme nous, l'apprentissage et le comportement humains sont beaucoup plus dynamiques et riches en données. Malgré leurs capacités, il est essentiel de reconnaître les limites de ces systèmes et notre compréhension de l'apprentissage humain.

Conclusion

Le développement continu des modèles de langage à grande échelle, comme GPT-4, promet de transformer notre interaction avec la technologie et d'ouvrir de nouvelles possibilités pour l'avenir de l'intelligence artificielle.

"L'intelligence artificielle est une technologie en constante évolution. Les modèles de langage à grande échelle, comme GPT-4, sont un exemple parfait de la manière dont cette technologie peut évoluer et s'améliorer avec le temps." - Citation anonyme

Pour en savoir plus sur les modèles de langage à grande échelle, vous pouvez consulter notre article :

| Modèle | Année de sortie | Capacités principales |

|---|---|---|

| GPT-1 | 2018 | Répondre à des questions simples |

| GPT-2 | 2019 | Produire du texte humain, accomplir des tâches spécifiques |

| GPT-3 | 2020 | Résolution de problèmes intégrée à d'autres processus |

| GPT-4 | 2023 | Interprétation de la vision par ordinateur, reconnaissance de l'humour, amélioration de la dirigeabilité |

En conclusion, l'évolution des modèles de langage à grande échelle est un domaine passionnant de l'intelligence artificielle qui continue de se développer et de s'améliorer. Avec des avancées comme GPT-4, l'avenir de l'IA est prometteur.

Source : Bluelabellabs