Meta AI présente Segment Anything : un modèle fondamental pour la segmentation d'images

Introduction à Segment Anything

Le 5 avril 2023, Meta AI a annoncé la sortie de son nouveau projet, appelé Segment Anything, qui vise à démocratiser la segmentation d'image. La segmentation consiste à identifier les pixels d'une image qui appartiennent à un objet et est une tâche fondamentale en vision par ordinateur. Elle est utilisée dans un large éventail d'applications, allant de l'analyse d'images scientifiques à l'édition de photos. Cependant, la création d'un modèle de segmentation précis pour des tâches spécifiques nécessite généralement un travail spécialisé effectué par des experts techniques ayant accès à des infrastructures d'apprentissage par IA et à de grandes quantités de données annotées avec soin.

Le modèle Segment Anything (SAM) et le dataset Segment Anything 1-Billion (SA-1B)

Avec le projet Segment Anything, Meta AI introduit un nouveau modèle, appelé Segment Anything Model (SAM), ainsi qu'un nouveau dataset, le Segment Anything 1-Billion mask dataset (SA-1B). Il s'agit du plus grand dataset de segmentation jamais créé, et il est conçu pour permettre un large éventail d'applications et encourager la recherche sur les modèles fondamentaux en vision par ordinateur. Le dataset SA-1B est disponible à des fins de recherche, et le modèle SAM est disponible sous une licence ouverte permissive (Apache 2.0). Il est également possible d'essayer le modèle SAM avec vos propres images grâce à une démo en ligne.

Fonctionnement de SAM

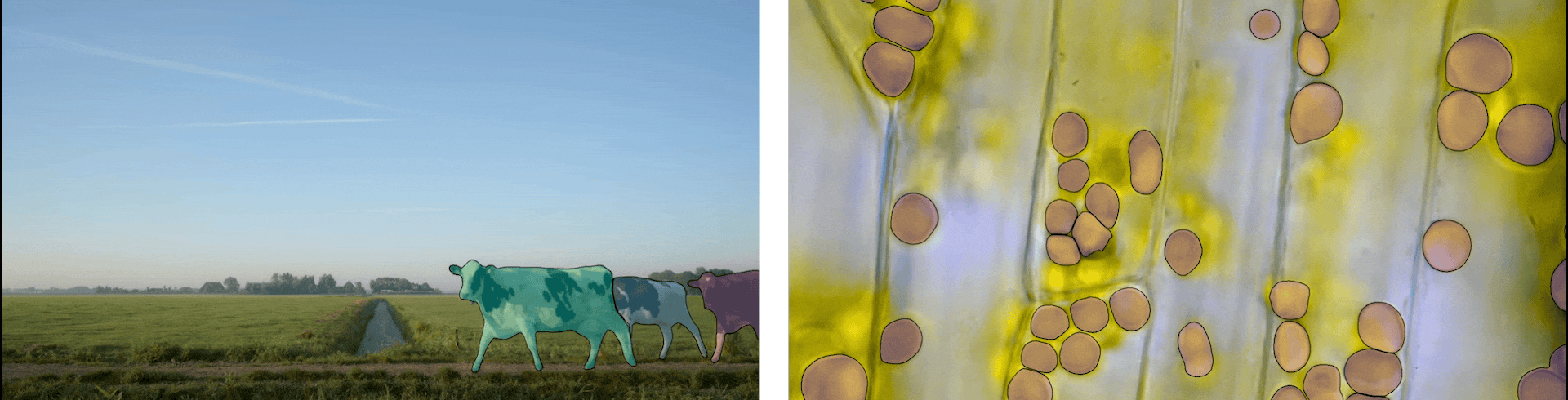

SAM est un modèle général qui peut effectuer à la fois la segmentation interactive et la segmentation automatique. Il est entraîné sur un dataset diversifié et de haute qualité comprenant plus d'un milliard de masques. Cette capacité à généraliser signifie que les praticiens n'auront généralement plus besoin de collecter leurs propres données de segmentation et d'affiner un modèle pour leur cas d'utilisation. Les capacités de SAM permettent de généraliser à la fois les nouvelles tâches et les nouveaux domaines, ce qui est une première pour la segmentation d'image.

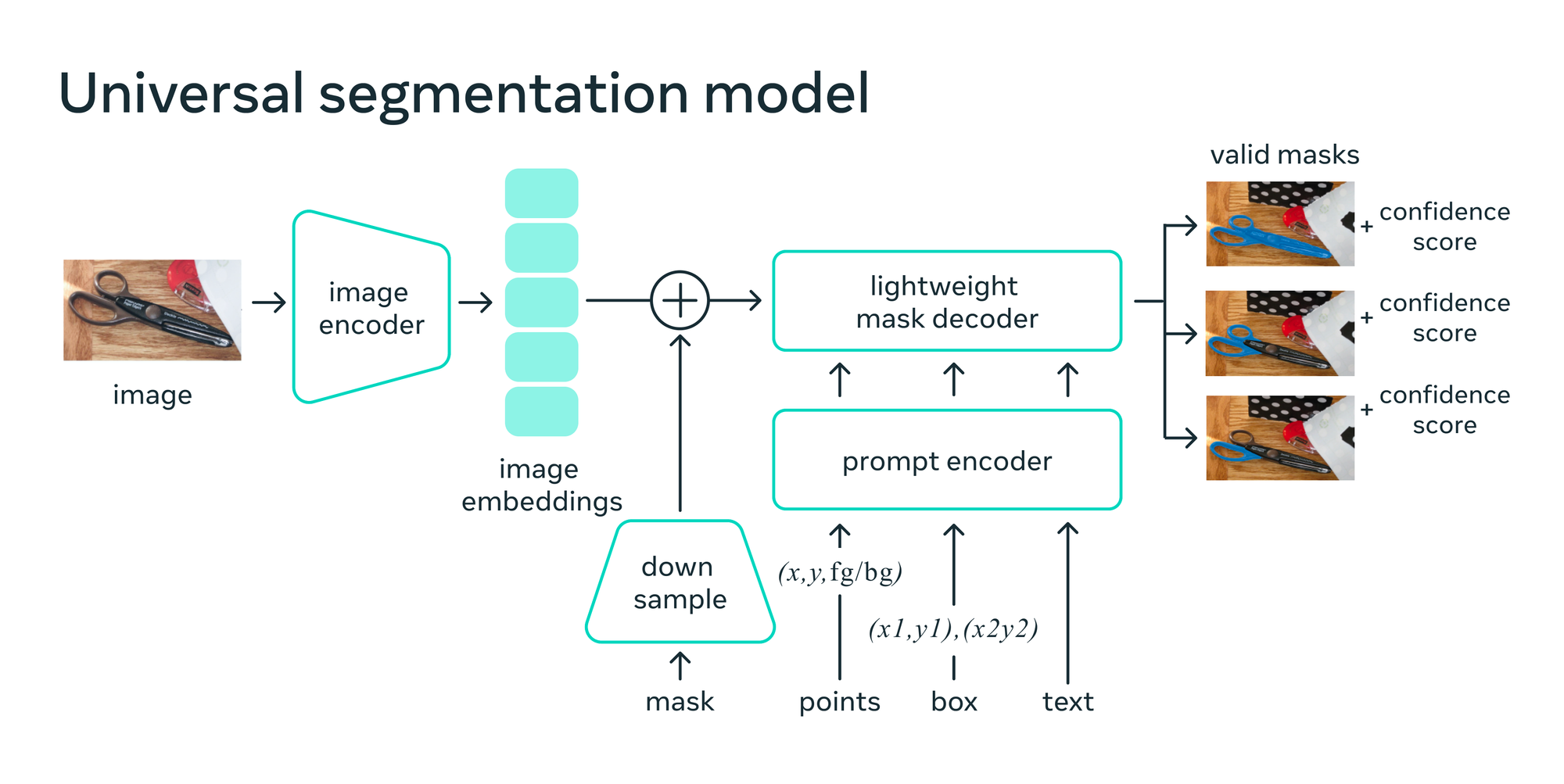

Segmentation promptable

Inspiré par les techniques de "prompting" utilisées dans le traitement du langage naturel et, plus récemment, en vision par ordinateur, SAM a été entraîné pour retourner un masque de segmentation valide pour n'importe quel prompt. Un prompt peut être des points d'avant-plan/arrière-plan, une boîte ou un masque grossier, du texte libre ou, en général, toute information indiquant ce qu'il faut segmenter dans une image.

Création du dataset SA-1B

Pour entraîner le modèle SAM, il était nécessaire de disposer d'une source de données massive et diversifiée, qui n'existait pas au début des travaux. Le dataset de segmentation SA-1B est le plus grand à ce jour. Il a été collecté à l'aide du modèle SAM, qui a été utilisé par des annotateurs pour annoter des images de manière interactive. Les données nouvellement annotées ont ensuite été utilisées pour mettre à jour le modèle SAM.

Le moteur de données SA-1B

Le moteur de données SA-1B comporte trois "vitesses". La première vitesse consiste en l'assistance du modèle aux annotateurs, comme décrit précédemment. La deuxième vitesse est un mélange d'annotation entièrement automatique combinée à l'annotation assistée, ce qui permet d'augmenter la diversité des masques collectés. La dernière vitesse du moteur de données est la création entièrement automatique de masques, ce qui permet d'augmenter l'échelle de notre dataset.

Le dataset final comprend plus de 1,1 milliard de masques de segmentation collectés sur environ 11 millions d'images sous licence et respectueuses de la vie privée. Le SA-1B contient 400 fois plus de masques que tout autre dataset de segmentation existant. Des études d'évaluation humaine ont confirmé que les masques sont de haute qualité et diversifiés, et dans certains cas, comparables en qualité aux masques des précédents datasets, entièrement annotés manuellement et bien plus petits.

Applications et perspectives

Le modèle SAM pourrait être utilisé pour alimenter des applications dans de nombreux domaines nécessitant de trouver et de segmenter n'importe quel objet dans n'importe quelle image. Pour la communauté de recherche en IA et d'autres domaines, SAM pourrait devenir un composant de systèmes d'IA plus vastes pour une compréhension multimodale générale du monde, par exemple, en comprenant à la fois le contenu visuel et textuel d'une page Web.

Domaine de l'AR

Dans le domaine de la réalité augmentée et virtuelle (AR/VR), SAM pourrait permettre de sélectionner un objet en fonction du regard de l'utilisateur, puis de le "soulever" en 3D. Pour les créateurs de contenu, SAM peut améliorer les applications créatives, telles que l'extraction de régions d'images pour des collages ou des montages vidéo. SAM pourrait également être utilisé pour aider à étudier des phénomènes naturels sur Terre ou même dans l'espace, par exemple, en localisant des animaux ou des objets à étudier et à suivre dans des vidéos.

La conception adaptable de Segment Anything permet une intégration flexible avec d'autres systèmes. Par exemple, SAM pourrait recevoir des invites d'entrée, telles que le regard d'un utilisateur à partir d'un casque AR/VR.

Conclusion

En partageant leurs recherches et leur dataset, Meta AI espère accélérer davantage la recherche dans la segmentation et la compréhension plus générale des images et des vidéos. SAM peut devenir un composant puissant dans des domaines tels que l'AR/VR, la création de contenu, les domaines scientifiques et les systèmes d'IA plus généraux. À l'avenir, on peut s'attendre à une intégration plus étroite entre la compréhension des images au niveau des pixels et la compréhension sémantique de niveau supérieur du contenu visuel, débloquant des systèmes d'IA encore plus puissants.

Source : Meta AI