De l'entrée à la réponse : comprendre le fonctionnement des chatbots basés sur les Transformers

Introduction

Dans le monde de l'intelligence artificielle (IA), les chatbots sont devenus un outil incontournable pour de nombreuses applications, allant du service client à l'assistance personnelle. Au cœur de ces chatbots, on trouve souvent une technologie appelée "Transformers". Mais que sont ces "Transformers" et comment fonctionnent-ils dans les chatbots ? C'est ce que nous allons découvrir.

Comprendre les Transformers

Les modèles de type Transformer sont une nouvelle avancée en matière d'apprentissage automatique qui fait beaucoup parler d'elle. Ils sont incroyablement doués pour capter le contexte, et c'est pourquoi les textes qu'ils génèrent ont du sens.

Pour avoir plus de détails sur les Tansformers, nous vous invitons à lire notre article dédié :

Le cheminement d'une phrase dans un Chatbot

Quand on interagit avec un chatbot, on se demande souvent comment il comprend ce qu'on lui dit et comment il génère des réponses. Pour le comprendre, prenons l'exemple d'une phrase simple : "Le chien cours après". Comment cette phrase est-elle traitée par un chatbot basé sur un Transformer ?

Tokenisation et Encodage : La première étape

La première chose que fait le chatbot est de diviser la phrase en "tokens". Un token est généralement un mot, mais il peut aussi être une partie de mot. Ainsi, notre phrase est divisée en ["le", "chien", "cours", "après"]. C'est ce qu'on appelle la tokenisation.

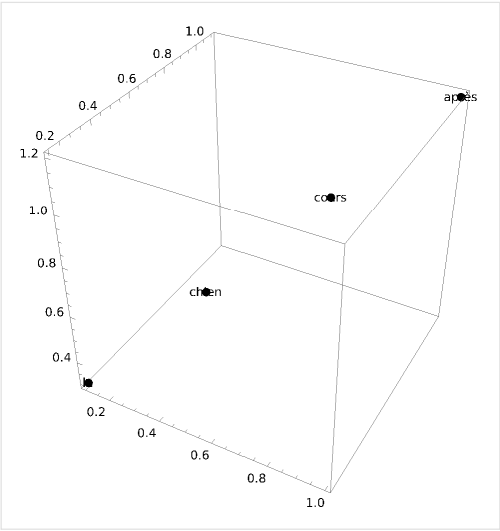

Les Word Embeddings : Transformation des mots en vecteurs

Ensuite, chaque token est transformé en un vecteur numérique. C'est ce qu'on appelle un "word embedding" ou une incrustation de mot. Pour simplifier, imaginons que notre chatbot transforme les mots en vecteurs de trois dimensions de cette façon :

"le" -> [0.1, 0.2, 0.3]

"chien" -> [0.4, 0.5, 0.6]

"cours" -> [0.7, 0.8, 0.9]

"après" -> [1.0, 1.1, 1.2]

Passage à travers le Transformer : Capturer le contexte

Ces vecteurs sont ensuite passés à travers le Transformer. Le Transformer calcule l'attention de chaque mot par rapport à tous les autres mots, ce qui donne une nouvelle représentation qui tient compte du contexte de chaque mot. Supposons que les vecteurs deviennent quelque chose comme ceci après le passage à travers le Transformer :

"le" -> [0.2, 0.3, 0.4]

"chien" -> [0.5, 0.6, 0.7]

"cours" -> [0.8, 0.9, 1.0]

"après" -> [1.1, 1.2, 1.3]

Comment le Transformer génère une réponse

Maintenant que notre chatbot a une représentation contextuelle de la phrase, comment génère-t-il une réponse ?

Génération autonome : Comment le modèle prédit le mot suivant

Ensuite, le modèle génère une réponse en prédisant le prochain mot. Supposons que notre modèle prédise "la" après "après". Il continue ensuite de prédire les mots suivants jusqu'à ce qu'il atteigne une fin de phrase ou une limite prédéfinie.

Disons que la réponse complète est : "la balle".

Veuillez noter que cette explication est très simplifiée. Dans la réalité, les vecteurs d'incrustation ont des centaines de dimensions et les calculs d'attention sont plus compliqués. De plus, le modèle ne génère pas la réponse en une seule étape, mais prédit un mot à la fois, en utilisant chaque nouveau mot comme entrée pour prédire le suivant.

Prise en compte du contexte : L'importance de tous les mots précédents

Il est important de noter que lorsqu'il prédit chaque nouveau mot, le Transformer prend en compte tous les mots précédents, pas seulement le dernier mot prédit. C'est ce qui lui permet de générer des réponses qui sont cohérentes et qui tiennent compte de tout le contexte d'entrée.

Pour résumer, quand vous envoyez une phrase à un chatbot, elle est décomposée en tokens, transformée en vecteurs, passée à travers un Transformer pour obtenir une représentation contextuelle, puis le chatbot génère une réponse en prédisant un mot à la fois, en tenant compte de tous les mots précédents.

C'est une simplification de ce qui se passe réellement, car en réalité, les vecteurs d'incrustation ont des centaines de dimensions et les calculs d'attention sont bien plus complexes. Cependant, cela donne une bonne idée du processus de base.

Les limites et les défis des chatbots basés sur les Transformers

Bien que les chatbots basés sur les Transformers soient puissants et offrent de nombreux avantages, ils présentent également certaines limites et défis.

Complexité computationnelle

L'un des principaux défis concerne la complexité computationnelle. Les Transformers sont des modèles très gourmands en ressources, nécessitant une grande quantité de puissance de calcul et de mémoire. Cela peut rendre leur utilisation difficile pour certaines applications, surtout lorsque le temps de réponse est critique.

Génération de réponses pertinentes et précises

Un autre défi est la génération de réponses pertinentes et précises. Même si les Transformers sont capables de comprendre le contexte et de générer des réponses basées sur ce contexte, ils peuvent parfois générer des réponses qui ne sont pas tout à fait précises ou pertinentes. Cela est dû en partie au fait qu'ils sont entraînés sur d'énormes quantités de texte et qu'ils peuvent parfois "imiter" le style d'écriture de ces textes sans comprendre réellement le sens.

Par exemple, si vous demandez à un chatbot "Quelle est la température sur la Lune ?", il pourrait répondre quelque chose comme "Je suis désolé, je ne suis pas capable de fournir des informations météorologiques actuelles", même si la question ne concerne pas la météo actuelle mais une information factuelle sur la Lune.

Conclusion

Les chatbots basés sur les Transformers sont des outils incroyablement puissants qui ont révolutionné notre façon de dialoguer avec les machines. Grâce à leur capacité à comprendre le contexte et à générer des réponses pertinentes, ils offrent une expérience d'interaction beaucoup plus naturelle et conviviale que les chatbots traditionnels.

Cependant, ils ne sont pas sans défis. La complexité computationnelle et la génération de réponses précises sont deux domaines dans lesquels des améliorations sont encore nécessaires. Mais avec les progrès continus dans le domaine de l'IA, nous pouvons nous attendre à voir des chatbots de plus en plus intelligents et capables à l'avenir.