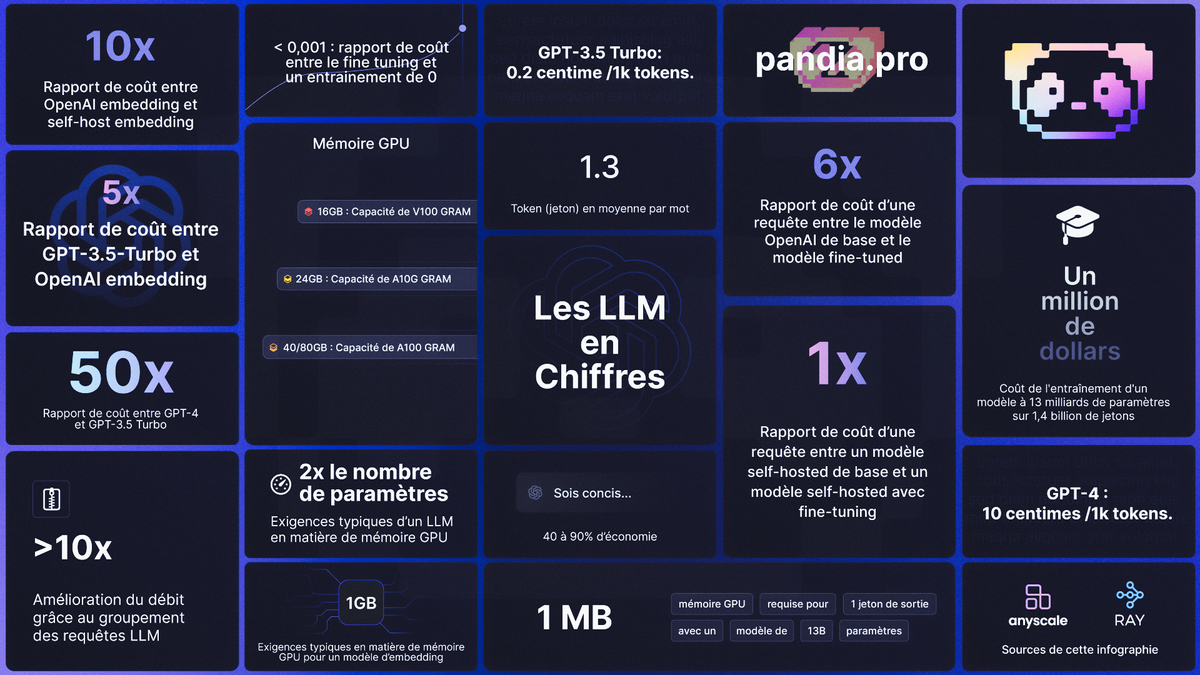

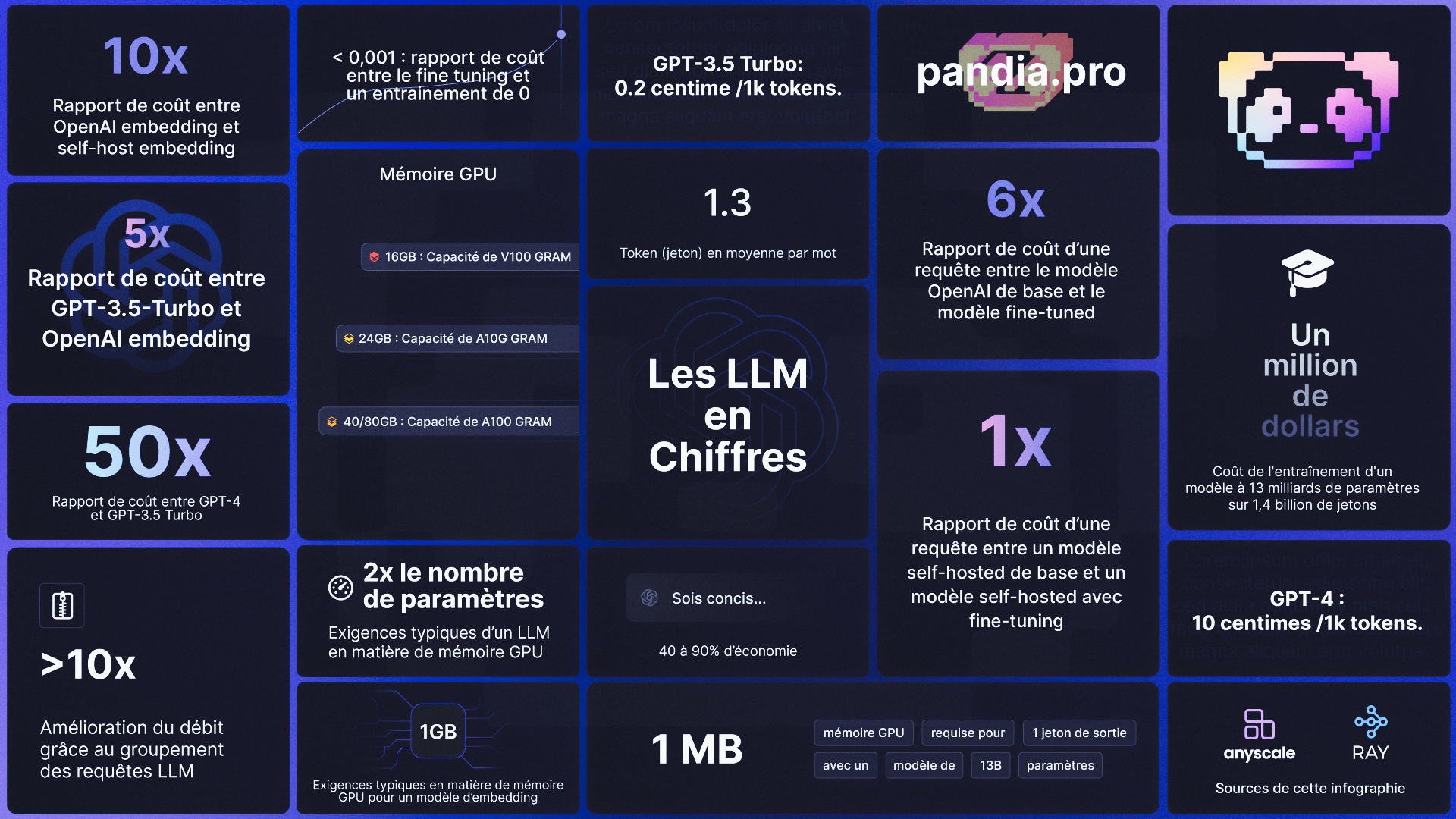

Les chiffres que chaque développeur LLM devrait connaître

Il est extrêmement utile pour les développeurs de modèles linguistiques à grande échelle (Large Language Models, LLM) d'avoir en tête un certain nombre de chiffres clés pour les calculs de base. Ainsi, nous allons présenter ici certains nombres, expliquer pourquoi ils sont importants et comment les utiliser à votre avantage.

Prompts

40-90% : économie réalisée en ajoutant "Sois Concis" à votre prompt. Il est important de se rappeler que vous payez au token pour les réponses. Cela signifie que demander à un LLM d'être concis peut vous faire économiser beaucoup d'argent.

1.3 : c'est le nombre moyen de tokens par mot. Les LLM fonctionnent sur des tokens, qui sont des mots ou des sous-parties de mots. Par exemple, "manger" pourrait être divisé en deux tokens "mang" et "er". Un document de 750 mots en français représentera environ 1000 tokens.

Tarifs

Bien sûr, les prix sont susceptibles de changer, mais étant donné le coût d'exploitation des LLM, les chiffres de cette section sont essentiels.

~50 : c'est le ratio de coût entre GPT-4 et GPT-3.5 Turbo. Cela signifie que pour de nombreuses applications pratiques, il est beaucoup plus rentable d'utiliser GPT-4 pour des tâches comme la génération de texte, puis d'utiliser ces données pour affiner un modèle plus petit. Il est environ 50 fois moins cher d'utiliser GPT-3.5-Turbo que GPT-4.

5 : c'est le ratio de coût entre la génération de texte en utilisant GPT-3.5-Turbo et l'intégration de texte OpenAI. Cela signifie qu'il est beaucoup moins cher de chercher quelque chose dans un magasin de vecteurs que de demander à un LLM de le générer.

10 : c'est le ratio de coût entre l'intégration OpenAI et l'intégration auto-hébergée. Ce chiffre est sensible à la charge et à la taille du lot d'intégration, veuillez donc considérer ce chiffre comme approximatif.

6 : c'est le ratio de coût entre les requêtes sur le modèle de base OpenAI et les requêtes sur le modèle affiné. Cela coûte 6 fois plus cher de servir un modèle affiné que le modèle de base sur OpenAI.

1 : c'est le ratio de coût entre les requêtes sur le modèle de base auto-hébergé et les requêtes sur le modèle affiné. Si vous hébergez vous-même un modèle, alors il en coûte plus ou moins le même montant pour servir un modèle affiné que pour servir un modèle de base : les modèles ont le même nombre de paramètres.

Entraînement et affinage

~1 million de dollars : c'est le coût pour entraîner un modèle de 13 milliards de paramètres sur 1,4 trillion de tokens. La formation de votre propre LLM est possible, mais elle n'est pas bon marché. Et cela prendra littéralement des jours pour terminer chaque course.

< 0.001 : c'est le ratio de coût entre l'affinage et l'entraînement à partir de zéro. C'est une généralisation, mais le coût de l'affinage est négligeable.

Mémoire GPU

Si vous hébergez vous-même un modèle, il est vraiment important de comprendre la mémoire GPU parce que les LLM poussent la mémoire de votre GPU à ses limites.

V100: 16GB, A10G: 24GB, A100: 40/80GB : ce sont les capacités de mémoire GPU. Il peut sembler étrange, mais il est important de connaître la quantité de mémoire que différents types de GPU ont.

2x nombre de paramètres : ce sont les exigences typiques de la mémoire GPU d'un LLM pour le service. Par exemple, si vous avez un modèle à 7 milliards de paramètres, il prend environ 14 Go d'espace GPU.

~1GB : ce sont les exigences typiques de la mémoire GPU d'un modèle d'intégration. Chaque fois que vous faites une intégration de phrases, vous avez besoin d'un modèle d'intégration comme SentenceTransformers.

>10x : amélioration du débit par le regroupement des requêtes LLM. C'est une amélioration significative du débit.

~1 MB : c'est la mémoire GPU nécessaire pour 1 token de sortie avec un modèle à 13B de paramètres.

Source :