Qu'est-ce que GPT (Generative Pre-trained Transformer) dans le domaine de l'IA ?

GPT, ou Generative Pre-trained Transformer (Transformeur génératif pré-entraîné en Français), est un modèle d'intelligence artificielle développé par OpenAI pour des tâches liées au traitement du langage naturel (NLP en anglais). Dans ce guide, nous allons explorer les caractéristiques et les applications de GPT.

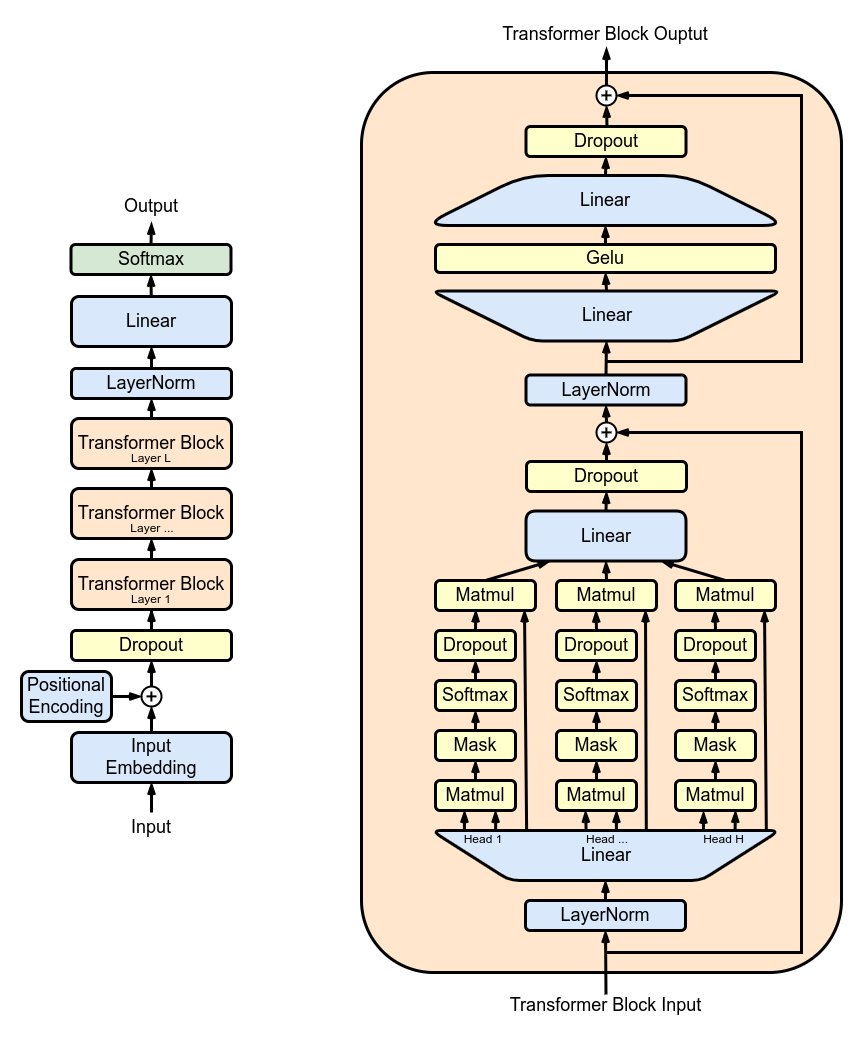

L'architecture Transformer

GPT utilise l'architecture dite Transformer. Cette architecture a révolutionné le domaine du traitement du langage naturel grâce à son mécanisme d'attention et sa capacité à traiter des séquences de texte importantes.

Attention, s'il vous plaît!

Le mécanisme d'attention est une innovation clé dans l'architecture Transformer. Il permet au modèle d'assigner des poids aux mots en fonction de leur pertinence et de leur contexte. Cela facilite la compréhension des relations entre les mots d'une phrase et améliore la qualité des prédictions du modèle.

Entraînement préalable

Comme son nom l'indique, GPT est un modèle pré-entraîné. Cela signifie qu'il a été alimenté et entraîné avec une grande quantité de texte provenant d'Internet avant même de l'utiliser pour des tâches spécifiques. Cette formation initiale lui permet d'apprendre la structure et la syntaxe du langage, ainsi que d'acquérir une connaissance générale sur divers sujets.

Applications de GPT

GPT est très polyvalent et peut être appliqué à de nombreuses tâches liées au langage naturel. Voici quelques exemples d'applications :

- La génération de texte : GPT est capable de générer du texte de manière cohérente et créative dans un style humain.

- La traduction automatique : GPT peut traduire un texte d'une langue à une autre avec une bonne précision.

- L'extraction de résumés : GPT peut générer des résumés concis à partir de longs documents.

- Les assistants virtuels : GPT peut être utilisé pour construire des assistants virtuels qui comprennent les questions des utilisateurs et fournissent des réponses pertinentes.

Limites de GPT

Bien que GPT soit une avancée majeure dans le domaine de l'IA, il a aussi ses limites. Par exemple, GPT peut parfois générer du texte incohérent ou imprécis. De plus, il a tendance à être sensible aux données d'entraînement utilisées et peut hériter des biais présents dans ces données.

En résumé, GPT est un modèle pré-entraîné basé sur l'architecture Transformer, il est développé par OpenAI pour aborder les défis du traitement du langage naturel. Il a déjà montré des résultats remarquables dans diverses tâches et applications, bien qu'il présente encore certaines limites.