Qu'est-ce qu'un Token (jeton), dans le domaine de l'intelligence artificielle (IA) ?

Dans le domaine de l'intelligence artificielle, en particulier lorsqu'on parle de traitement du langage naturel (TLN), un token est une unité de base pour analyser et traiter le texte. Généralement, un token représente un mot, une ponctuation, ou un autre élément du langage, selon le contexte et l'objectif de l'analyse.

Rôle des tokens en IA et NLP

Les tokens jouent un rôle central dans le traitement du langage naturel, car ils permettent de simplifier et d'organiser le texte en unités plus faciles à analyser. Lorsqu'un texte est tokenisé, cela signifie qu'il est divisé en tokens individuels.

Voici un exemple simple pour illustrer la tokenisation d'une phrase :

"L'intelligence artificielle est fascinante."

La phrase ci-dessus peut être tokenisée de la manière suivante :

- L'

- intelligence

- artificielle

- est

- fascinante

- .

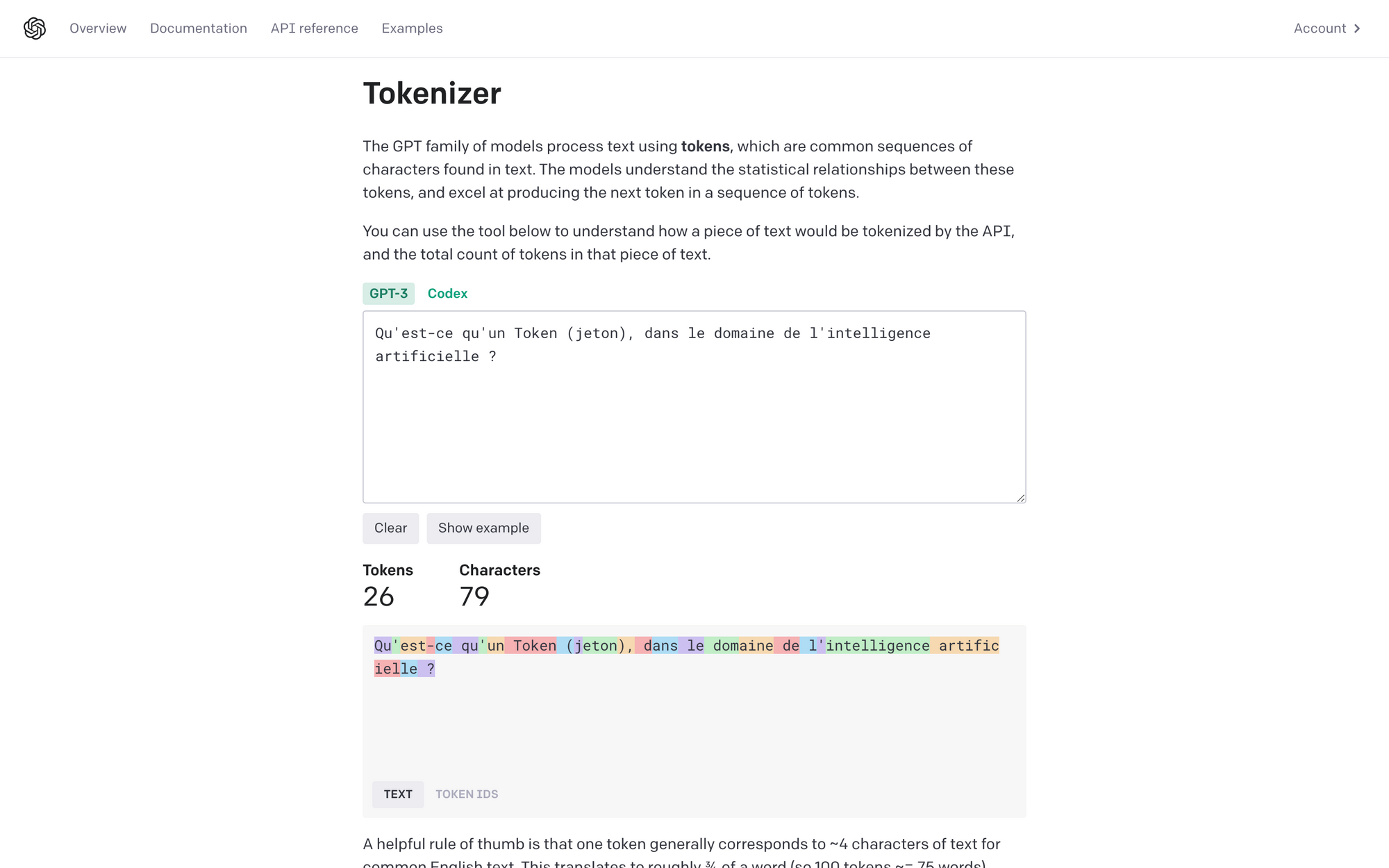

Vous pouvez utiliser le Tokenizer d'OpenAI pour décomposer du texte en tokens.

Utilisations des tokens en IA

La tokenisation est une étape cruciale dans de nombreuses tâches de traitement du langage naturel, telles que :

- Analyse de sentiment : déterminer si un texte exprime un sentiment positif, négatif ou neutre.

- Reconnaissance d'entités nommées : identifier et classer les entités, comme les noms propres, les lieux et les organisations, dans un texte.

- Traduction automatique : convertir un texte d'une langue à une autre.

- Génération de texte : créer du texte de manière autonome et cohérente, à partir d'une entrée donnée.

Tokens et modèles de langage

Les modèles de langage, tels que BERT ou GPT, sont des exemples de modèles d'apprentissage profond qui utilisent des tokens pour traiter et générer du texte. Ces modèles sont pré-entraînés sur de vastes ensembles de données textuelles pour apprendre la structure et les relations entre les mots et les phrases.

Dans ces modèles, les tokens sont souvent convertis en vecteurs (représentations numériques) à l'aide d'une technique appelée plongement de mots (word embedding). Les vecteurs permettent au modèle d'apprendre et de généraliser les relations sémantiques entre les tokens, améliorant ainsi les performances dans diverses tâches de NLP.

En résumé, un token est une unité de base utilisée pour analyser et traiter le texte en intelligence artificielle et en traitement du langage naturel. Les tokens facilitent la compréhension et la manipulation des textes, en les divisant en unités plus simples et plus faciles à traiter.