PrivateGPT : Un outil de question-réponse local et privé

Introduction

PrivateGPT est un outil d'intelligence artificielle qui vous permet d'interroger vos documents sans connexion Internet. Il utilise la puissance des Modèles de Langage à Long terme (LLM) pour fournir des réponses précises à vos questions. Le principal avantage de cet outil est qu'il est 100% privé et aucune donnée ne quitte votre environnement d'exécution à aucun moment.

Fonctionnement

L'outil est construit avec LangChain, GPT4All et LlamaCpp. Il permet d'ingérer des documents et de poser des questions sans avoir besoin d'une connexion Internet.

PrivateGPT utilise les outils LangChain pour analyser le document et créer des embeddings localement à l'aide de LlamaCppEmbeddings. Les résultats sont ensuite stockés dans une base de données vectorielle locale en utilisant Chroma vector store.

Pour poser une question, l'utilisateur doit exécuter une commande. L'outil utilise ensuite un LLM local basé sur GPT4All-J ou LlamaCpp pour comprendre les questions et créer des réponses. Le contexte pour les réponses est extrait de la base de données vectorielle locale en utilisant une recherche de similarité pour localiser le bon contexte dans les documents.

Configuration de l'environnement

Pour configurer votre environnement afin d'exécuter le code de privateGPT, vous devez d'abord installer toutes les exigences en utilisant pip. Ensuite, vous devez télécharger les deux modèles et les placer dans un répertoire de votre choix. Vous pouvez ensuite renommer le fichier example.env en .env et modifier les variables comme il convient.

Ingestion de votre propre jeu de données

Pour ingérer votre propre jeu de données, vous pouvez placer tous vos fichiers .txt, .pdf, ou .csv dans le répertoire source_documents. Ensuite, exécutez la commande python ingest.py pour ingérer toutes les données. Cela créera un dossier db contenant la base de données vectorielle locale. Le processus d'ingestion ne fait pas sortir les données de votre environnement local.

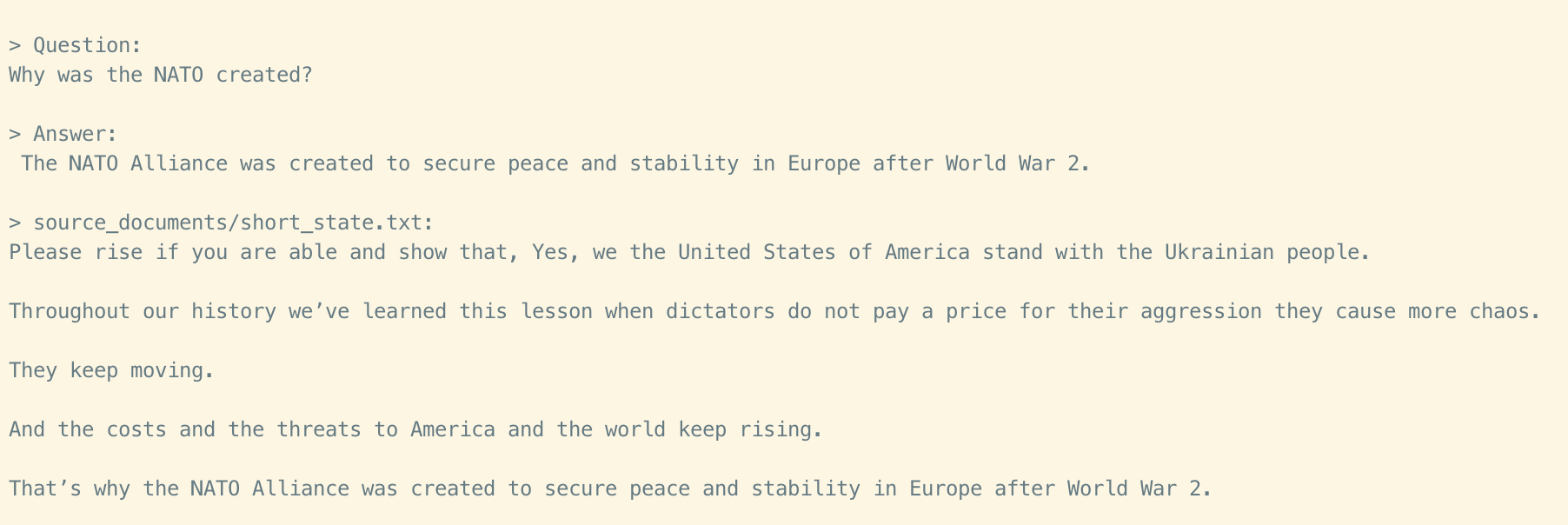

Interrogation de vos documents, localement

Pour poser une question, exécutez une commande comme python privateGPT.py et attendez que le script demande votre entrée. Vous devrez attendre que le modèle LLM consomme l'invite et prépare la réponse. Une fois terminé, il affichera la réponse et les 4 sources qu'il a utilisées comme contexte à partir de vos documents.

Exigences du système

Pour utiliser ce logiciel, vous devez avoir Python 3.10 ou une version ultérieure installée. De plus, si vous rencontrez une erreur lors de la construction d'une roue pendant le processus d'installation pip, vous devrez peut-être installer un compilateur C++ sur votre ordinateur.

Conclusion

PrivateGPT est un projet de test pour valider la faisabilité d'une solution totalement privée pour répondre aux questions en utilisant des LLMs et des embeddings vectoriels. Il n'est pas prêt pour la production et n'est pas destiné à être utilisé en production. Cependant, il démontre le potentiel des technologies de traitement du langage naturel pour une utilisation privée et sécurisée.