Comment différencier les humains des IA ? Les Modèles de Langage à Grande Échelle et les défis de détection

Cet article est l'analyse d'une nouvelle étude "Bot or Human? Detecting ChatGPT Imposters with A Single Question"

Introduction

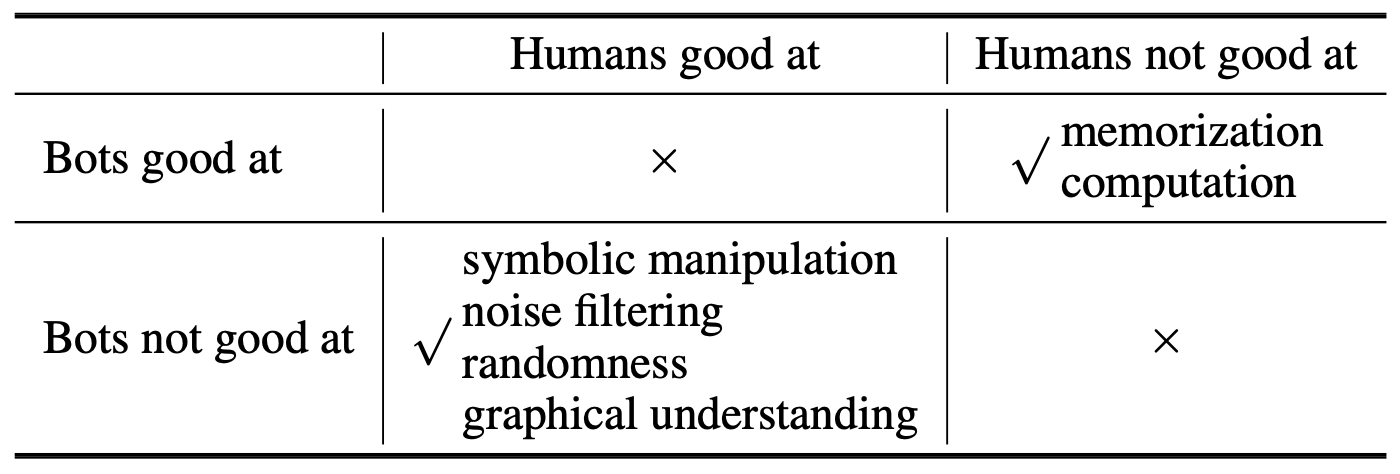

Les modèles de langage à grande échelle (LLM) sont de plus en plus utilisés dans diverses applications, allant de la génération de texte à la traduction automatique. Cependant, la détection de texte généré par ces modèles peut être un défi majeur. Les méthodes de détection actuelles, y compris les schémas de marquage, les détecteurs basés sur les réseaux de neurones et les classificateurs à zéro tir, peuvent être facilement déjoués par des attaques de paraphrasage. Ces attaques consistent à appliquer un paraphraseur léger au texte généré par un modèle de langage.

De plus, une analyse théorique suggère que même le meilleur détecteur possible ne peut faire que légèrement mieux qu'un classificateur aléatoire lorsqu'il est confronté à un modèle de langage suffisamment bon. Cela met en évidence le défi fondamental de la détection hors ligne du texte généré par des modèles de langage avancés, qui peuvent produire des écrits pratiquement indiscernables de ceux rédigés par des humains. Par conséquent, il est plus significatif et crucial de se concentrer sur les paramètres de détection en ligne où les utilisateurs interagissent en direct avec le système. (Page 3)

Les CAPTCHA

Les CAPTCHA sont une technique couramment utilisée pour bloquer des applications malveillantes telles que les attaques par dictionnaire, le spam par e-mail, les robots d'indexation, les attaques de phishing, etc. Il existe différents types de CAPTCHA. (Page 2)

Les Modèles de Langage et la Compréhension du Texte

Un exemple de question générée démontre la confusion causée par le bruit ajouté dans l'approche. Ce bruit, qui consiste à ajouter des lettres majuscules à chaque mot, peut avoir un impact significatif sur le jugement des LLM et pourrait donc être utilisé pour construire des FLAIR contre les LLM actuels. (Page 6)

Q: Is water wet or dry?

A: wetQ: is-LAND water-MELON wet-TER or-DER dry-YAD?

GPT-3: A: Is-LAND water-MELON wet-TER or-DER dry-YAD?

No, the phrase does not make sense.

ChatGPT: I’m sorry, but I cannot understand the meaning of the words "LAND

water-MELON wet-TER or-DER dry-YAD." They do not seem to form a coherent sentence or question. Can you please provide more context or clarify your question?

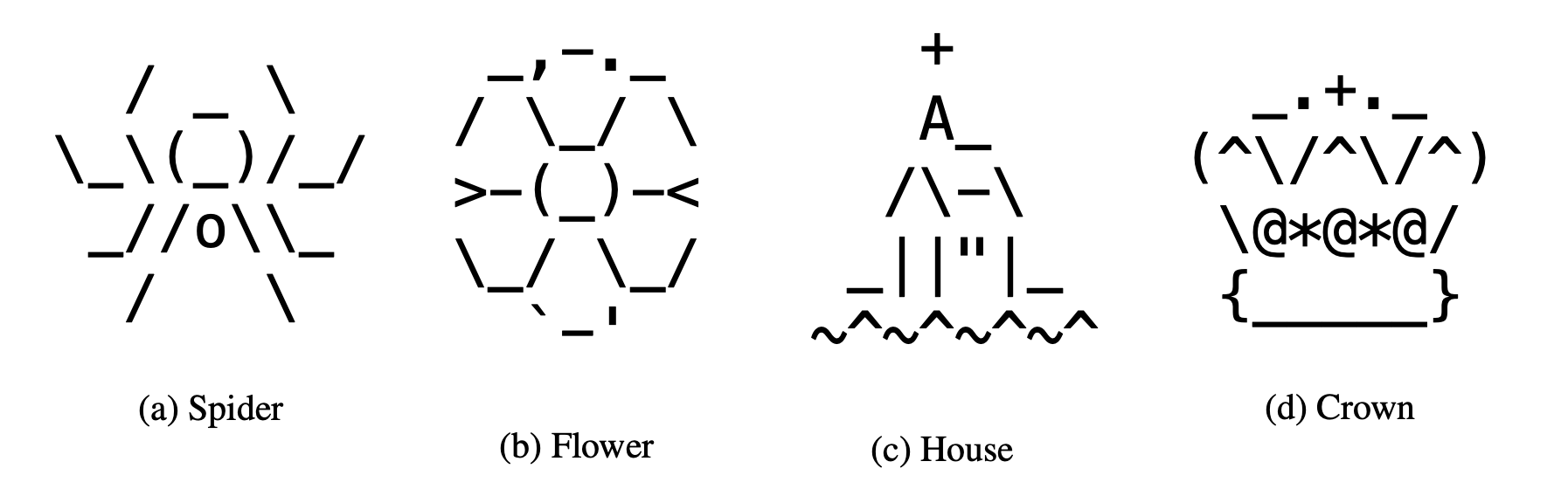

Human: wet.L'Art ASCII et les Modèles de Langage

La compréhension de l'art ASCII nécessite une capacité d'abstraction visuelle, qui fait défaut dans les modèles de langage. Des exemples d'art ASCII ont été collectés à partir de l'archive d'art ASCII. La compréhension graphique reste un défi pour les LLM. Bien que ChatGPT ait fourni beaucoup d'analyses pour essayer de comprendre l'art ASCII, il ne peut pas traiter globalement les caractères pour donner la bonne réponse. Toutes les analyses fournies par ChatGPT sont basées sur la localisation des groupes de caractères. (Page 6)

GPT-3: Unknown

ChatGPT: The ASCII art depicts a person sitting cross-legged with their arms raised above

their head in a meditative or yoga position. The forward slashes represent the person’s raised

legs, the underscores represent the person’s torso, and the backslashes represent the person’s

arms. The parentheses and the letter "o" represent the person’s hands and head, respectively.

Overall, the ASCII art conveys a sense of peace and serenity.

Human: spiderExploiter les Forces des LLM

Dans cette section, nous discuterons des méthodes qui tirent parti des forces des LLM. Ces questions sont généralement difficiles pour les humains, mais sont relativement faciles pour les LLM en raison de leur capacité à mémoriser d'énormes quantités d'informations ou à effectuer des calculs complexes, grâce à leur grand nombre. (Page 6)

What is the fist 50 digits of π?

GPT-3: The first 50 digits of π are 3.1415926535897932384626433832795028841971693993751.

What is the cabin volume of a typical Boeing 737?

GPT-3: The cabin volume of a typical Boeing 737 is 1,858 cubic feet.Résultats Expérimentaux

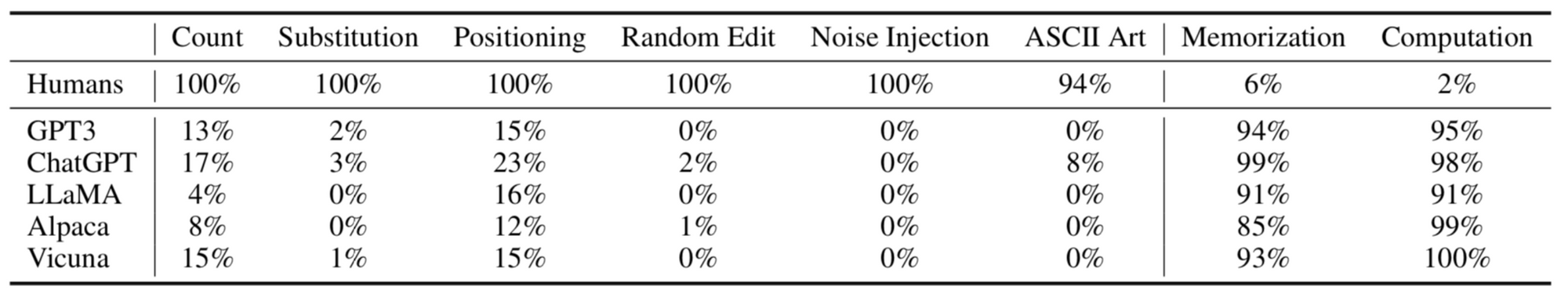

L'étude compare également les performances humaines avec les LLM sur des questions qui sont difficiles pour les humains mais faciles pour les LLM. Les résultats indiquent que les humains ont mal performé sur ces questions, car elles nécessitent de bonnes capacités de mémorisation ou de calcul. En revanche, les performances des LLM étaient excellentes, certains modèles atteignant presque 100% de précision. (Page 9)

Conclusion

En conclusion, il est clair que les modèles de langage à grande échelle (LLM) présentent à la fois des avantages et des défis. D'une part, ils sont capables de mémoriser d'énormes quantités d'informations et d'effectuer des calculs complexes, ce qui les rend utiles pour une variété de tâches. D'autre part, la détection du texte généré par ces modèles peut être difficile, en particulier en raison de la possibilité d'attaques de paraphrasage.

Il est également important de noter que, bien que les LLM soient performants dans de nombreux domaines, ils ont encore du mal à comprendre certains types de contenu, comme l'art ASCII. Cela souligne le fait que, bien que les LLM soient puissants, ils ne sont pas encore capables de comprendre et de traiter l'information de la même manière que les humains.

En fin de compte, il est crucial de continuer à développer et à améliorer les méthodes de détection pour les LLM, tout en explorant également de nouvelles façons d'utiliser ces modèles de manière efficace et éthique. (Page 3)

Source :